NO.PZ2022120202000008

问题如下:

State whether each of the following statements is true or false and explain why.

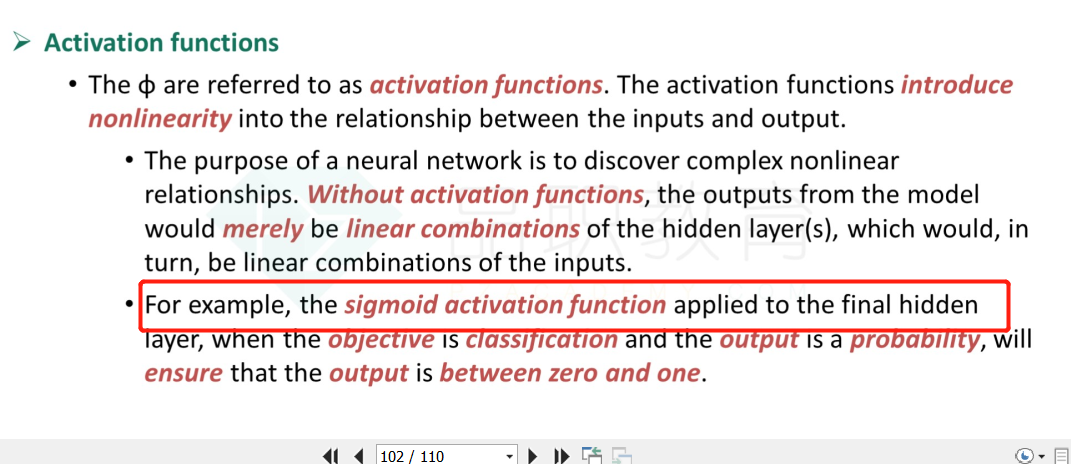

a. A neural network with no activation function is a linear regression model.

b. A neural network with no hidden layer is a linear regression model.

c. The bias in a neural network acts like the constant term in a regression.

选项:

解释:

a. True. It is the activation function that adds nonlinearity to the network architecture; without it, the model would simply be a linear combination of a linear combination of the features, which would overall result in the output variable being a linear combination of the input variables.

b. False. An activation function might be applied to the inputs to get the outputs. An example of this is logistic regression which applies the sigmoid function to the inputs.

c. True. The bias is analogous to the constant term in a regression and it allows for situations where the weighted inputs to a particular layer do not have the same mean as the output.

b和c请讲解下,谢谢